23. Juni 2021 | Fabian Oppel

um Einstieg ein kurzer biografischer Exkurs (wirklich kurz, versprochen :-) ): Ich habe einige Zeit bei einer Gastfamilie in den USA verbracht. Irgendwann sprach ich mit den Gast-Eltern darüber, dass in Deutschland viele Hollywood-Produktionen unverändert in den Kinos laufen – nur eben synchronisiert. Da waren die Eltern baff: „Aber die Mundbewegungen passen dann doch gar nicht!“, protestierte zum Beispiel die Gastmutter.

Wiederum einige Film-Enthusiasten stören sich daran, dass die Stimmen aus der Synchro manchmal einfach nicht passen, wenn man die DarstellerInnen einmal im Original gehört hat. Auch wenn die Stimmfarben einander ähneln, es gehe doch immer etwas verloren bei der Synchronisation. Das sieht auch GIM Research Director Sebastian Maetje so.

Sebastian ist GIM Experte für Digital- und Social-Media-Forschung, studierter Kulturwissenschaftler und ganz nebenbei Cineast. Mit ihm habe ich über zwei Innovationen gesprochen, die die jahrzehntelang gängige Praxis der Spielfilm-Synchronisation aufmischen könnten.

Synchronisation ohne neue Stimmen: deepdub

Das Israelisches Start-Up deepdub hat eine Software gelauncht, die mittels Künstlicher Intelligenz die Sprachsequenzen der Originalversion in eine andere Sprache überführt – und dabei die Originalstimme der SchauspielerInnen erhält! So titelte beispielsweise die Tagesschau „Plötzlich kann Morgan Freeman Deutsch!“ – Natürlich kann er kein Deutsch, aber deepdub spricht in seiner Stimme.

Demovideo mit automatisch generierten Übersetzungen in Originalstimme von deepdub.

„Die Technik von Deepdub beeindruckt mich sehr“, sagt Sebastian. „Die Original-Stimmen der Schauspielerinnen und Schauspieler beizubehalten, das ist bis jetzt nicht denkbar.“ Natürlich müsse man noch eine entsprechend lange Arbeitsprobe abwarten, um zu beurteilen, wie z.B. mehrere zusammenhängende Sätze am Stück klingen, aber das, was deepdub bisher vorgelegt hat, mache neugierig auf mehr.

Der Israelische Journalist Ben Mittelman gibt Sprachproben, die mit der Software in verschiedene Sprachen überführt wird.

Lippenbewegungen anpassen: Flawless

Die unpassende Stimme bei der Synchro wäre mit deepdub gelöst. Bleibt aber noch das Problem mit den unpassenden Lippenbewegungen.

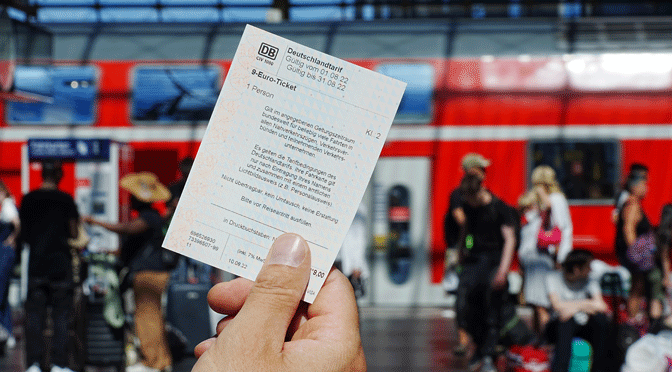

Tatsächlich, es gibt Szenen, in denen passen die Mundbewegungen trotz noch so professionell gemachter Synchronisation einfach nicht zur Übersetzung. Ein Beispiel: Im ersten Harry-Potter-Film sollen Jung-Zauberer auf Besen fliegen lernen. Dazu wird der Besen vom Boden in die Hand gerufen, mit dem Befehl „Auf!“. Im englischen Original „Up!“. Egal wie, die deutsche Übersetzung passt hier einfach nicht auf die Mundbewegungen im Original. Ein Problem, um das man bisher nicht herumkam, wenn man den Film in der Synchronfassung schauen wollte oder musste.

Hier die englische Originalszene, in der die Zauberschüler „Up!“ rufen, in der deutschen Version mit „Auf!“ übersetzt.

Nun bietet ein internationales Start-Up mit Hauptsitz in London eine Technik für die Film-Industrie an, die eigentlich aus sogenannten „Deep-Fakes“ bekannt ist: Gestützt auf Künstliche Intelligenz rechnet die Software von Flawless passende Mundbewegungen für die Synchronisations-Sprache und setzt diese auf die originalen Film-Sequenzen.

Ein deutsches Demo-Video von Flawless.

Ohne Frage, die Technik liefert erstaunliche Ergebnisse. Aber gemessen mit dem Anspruch eines Hollywood-Films wirkt der Output noch hölzern, die Künstlichkeit der Lippen-Bewegungen ist aktuell deutlich zu erkennen. Auch Sebastian ist noch nicht überzeugt: „Die Idee, Mundbewegungen künstlich zu verändern, ist für mich ein zweischneidiges Schwert: Einerseits möchte ich als Filmfan nicht, dass an den Original-Aufnahmen etwas verändert wird. Wenn die Technik jedoch irgendwann so ausgereift ist, dass diese Veränderungen zu einem noch immersiveren Filmerlebnis führen, macht für mich auch der Einsatz Sinn. Die Demo-Aufnahmen konnten mich jedoch noch nicht überzeugen.“

Zukunft der film-Synchro unterstützt durch Künstliche Intelligenz

Dass Spielfilme digital erstellt werden, ist ein alter Hut. Längst nutzen Filmemacher digitale Tools wie computergenerierte Bilderstellung standardmäßig – eines der eindrucksvollsten Beispiele ist „Avatar“ von 2009, bei dem ein Großteil des Films erst im Rechner entstand. Mittels Künstlicher Intelligenz verschiedene Sprachversionen zu erstellen, eröffnet nun aber neue Möglichkeiten.

Dass alle internationalen Blockbuster in naher Zukunft mit künstlicher Intelligenz ohne Synchronsprecherinnen und -sprecher auskämen, scheint im Moment dennoch unrealistisch – dazu ist die Technik einfach noch nicht ausgereift genug. Trotzdem gibt es denkbare Use-Cases abseits Hollywoods. Reportagen, Sport-Berichterstattung und Interviews im Allgemeinen könnten von den neuen Technologien durchaus profitieren. Vorstellbar wäre aber auch, dass Produktionen mit kleinerem Budget auf automatisierte Synchronisationen setzen, da hier die Kosten – zumindest nach Angaben der Betreiber von deepdub – geringer sind als bei einer klassischen Synchronisation. Genauso könnten aber auch ältere Filme digital synchronisiert werden, in denen für gewöhnlich noch etwas langsamer und deutlicher gesprochen wurde.

Klar ist also: Die Zukunft der Filmsynchronisation bekommt digitale Unterstützung, die immer mehr Arbeit übernehmen kann :-)

Kontakt

Bei Fragen und Rückmeldung zum Thema könnt ihr jederzeit gern auf Sebastian zukommen! :-)

Sebastian Maetje

Research Director

S.Maetje@g-i-m.com

Headerbild: Jake Hills/unsplash